Le modèle GPT-2 est l’un des premiers modèles de traitement du langage naturel développé par OpenAI en 2019. Doté de milliards de paramètres et entraîné sur des quantités massives de données textuelles, GPT-2 a démontré une capacité impressionnante à générer des textes cohérents et réalistes dans divers domaines. Cependant, en raison des risques potentiels d’utilisation malveillante, OpenAI a pris la décision controversée de ne publier que certaines versions restreintes du modèle. Dans cette section, nous allons examiner les principales caractéristiques, innovations et impacts de GPT-2 dans le monde de l’intelligence artificielle.

Qu’est-ce que GPT-2 ?

GPT-2, ou Generative Pre-trained Transformer 2, est un modèle de traitement du langage naturel développé par OpenAI et lancé en février 2019.

Il a été conçu comme un système d’apprentissage polyvalent, capable de traiter diverses tâches liées au traitement du langage naturel, telles que la traduction, la réponse aux questions, le résumé et la génération de textes.

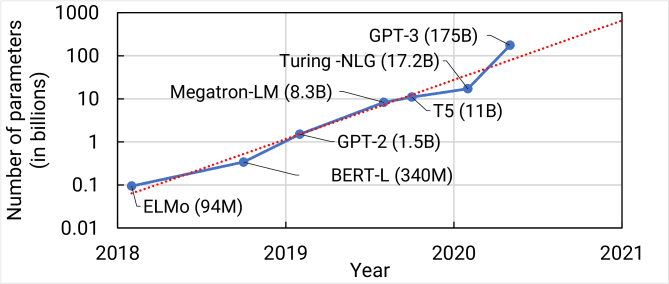

GPT-2 est une évolution majeure par rapport à son prédécesseur, GPT-1, avec dix fois plus de paramètres et une taille de jeu de données d’entraînement considérablement augmentée.

Capacités et Innovations

L’une des principales innovations de GPT-2 réside dans son approche d’apprentissage « Zero-shot ».

Cette méthode permet au modèle de traiter des textes qu’il n’a jamais vus auparavant en évaluation, en utilisant des plongements de mots et de classes pour relier les textes à des thèmes connus. Cela facilite la reconnaissance et la génération de réponses pertinentes, même sur des sujets non représentés dans l’ensemble de données d’entraînement.

GPT-2 a démontré des capacités impressionnantes dans la génération de textes cohérents et réalistes, au point d’être parfois indiscernables de ceux écrits par un humain.

Cependant, le modèle peut également produire des textes répétitifs ou dénués de sens sur de longs passages, ce qui souligne la nécessité d’améliorer davantage les modèles de traitement du langage naturel.

Controverses et Gestion des Risques

Le lancement de GPT-2 n’a pas été sans controverse. OpenAI a initialement retenu la publication du code source complet du modèle, invoquant des risques d’utilisation malveillante, tels que la création de désinformation ou de contenus offensants.

Cette décision a suscité un débat important dans la communauté de l’apprentissage automatique, certains critiquant l’organisation pour ne pas avoir ouvert le code source, tandis que d’autres comprenaient la prudence d’OpenAI face aux risques potentiels.

Évolution et Gestion des Risques

- OpenAI a continué à développer sa méthodologie pour gérer les risques associés à ses modèles d’IA, notamment avec les modèles GPT-3 et GPT-4.

- En partenariat avec Microsoft, OpenAI a travaillé sur la détection et la perturbation des menaces cybernétiques liées aux modèles de langage.

- L’approche prudente d’OpenAI, consistant à ne pas rendre les poids des modèles largement disponibles, a permis de continuer à contrôler et atténuer les risques après le lancement initial des modèles.

Bien que GPT-2 soit désormais surpassé par des modèles plus récents comme GPT-3 et GPT-4, ses contributions au domaine de l’IA et ses leçons en termes de gestion éthique des technologies restent d’une grande importance. L’approche d’OpenAI, mélangeant innovation et gestion responsable des risques, continue d’influencer la manière dont les modèles d’IA sont développés et déployés dans des domaines à risque élevé.