Présentation de Mixtral 8x7B

Mixtral-8x7B est une nouvelle technologie d’IA développée par Mistral AI.

Cette technologie offre des performances similaires à celles de GPT-3.5 et Llama 2 70B, tout en nécessitant moins de ressources matérielles pour son inférence.

Architecture SMoE : Le Secret de la Performance de Mixtral

La performance de Mixtral 8x7B est en grande partie due à l’architecture SMoE (Sparse Mixture of Experts). Cette architecture permet un découpage stratégique des performances, rendant le processus de réponse à une requête plus ciblé et efficace.

- Le modèle dispose de 8 groupes d’experts distincts, chacun spécialisé dans différents aspects du traitement du langage.

- Pour chaque token du prompt, un réseau de routage sophistiqué sélectionne les deux groupes d’experts les plus pertinents pour le traiter, et combine leurs sorties de façon additive.

Capacités de Mixtral 8x7B

Mixtral-8x7B est capable de gérer un grand nombre de paramètres (85 milliards au total) tout en maintenant une efficacité comparable à un modèle de 14 milliards lors de l’inférence.

Cette efficacité est due au fait que pour chaque token, seule une fraction des paramètres totaux sont utilisés.

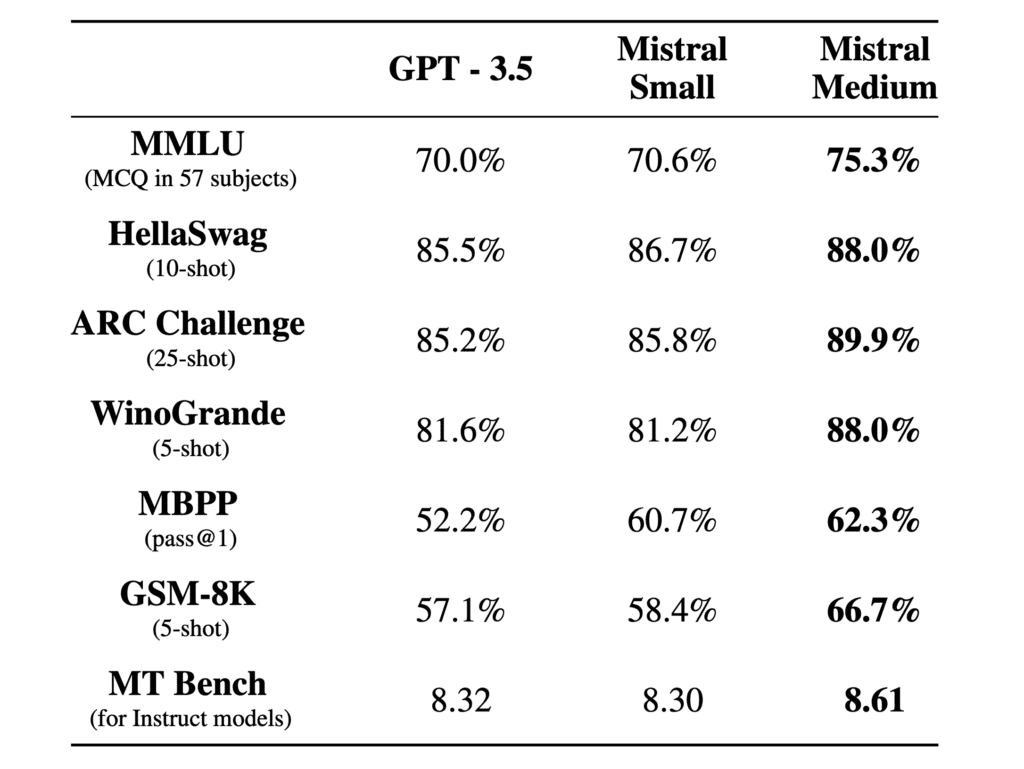

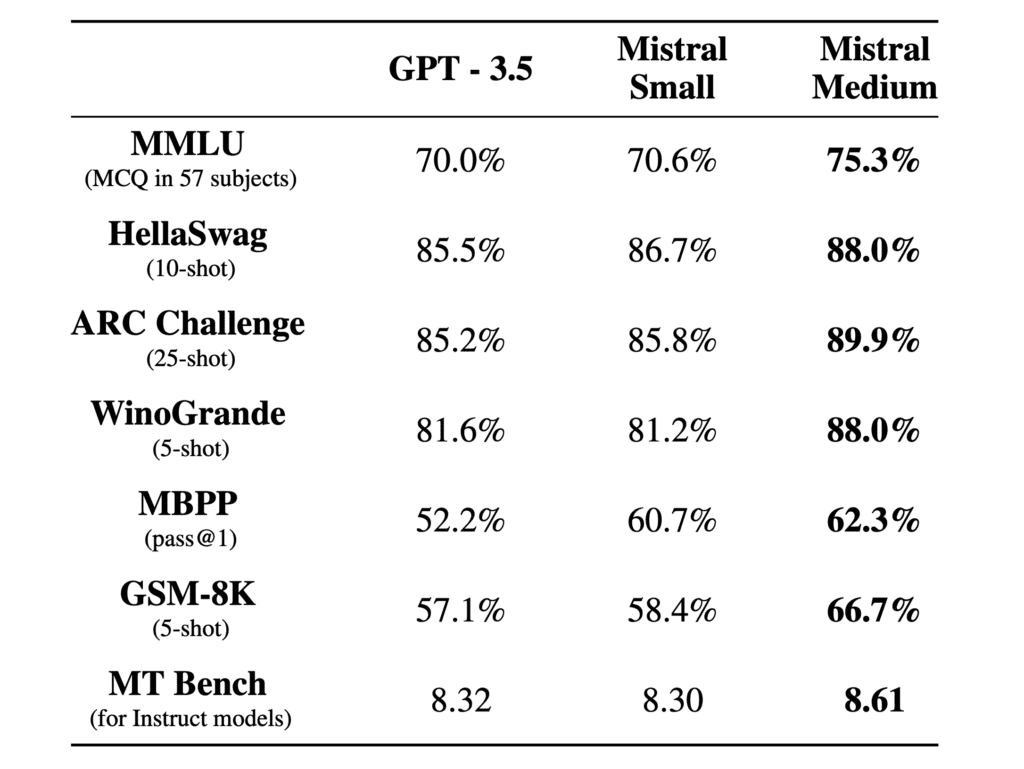

Performances de Mixtral

Selon les benchmarks menés par les équipes de Mistral AI, Mixtral performe mieux que Llama 2 70B et GPT-3.5 sur une multitude de tâches.

Par exemple, sur le benchmark MMLU de questions à choix multiples couvrant 57 sujets, Mixtral 8x7B affiche un taux de réussite de 70,6%, légèrement supérieur aux 69,9% de LLaMA 2 70B et presque équivalent aux 70% de GPT-3.5.

Mistral AI : La Société derrière Mixtral

Présentation de Mistral AI

Mistral AI est une start-up française spécialisée dans l’intelligence artificielle générative.

Fondée par Arthur Mensch, Guillaume Lample et Timothée Lacroix, la société a réussi à lever des fonds importants pour développer ses technologies d’IA.

Modèles de Langage de Mistral AI

Depuis sa création, Mistral AI a développé plusieurs modèles de langage, dont le Mistral 7B et le Mixtral 8x7B.

Ces modèles ont été téléchargés des millions de fois et sont réputés pour leur efficacité énergétique.

Commercialisation des Modèles de Mistral AI

Mistral AI a développé une plateforme commerciale pour intégrer directement les modèles de génération de texte Mistral 7B et Mixtral dans des applications.

Cette plateforme, actuellement en version beta, sera rendue disponible début 2024.

Comparaison avec d’autres Modèles d’IA

Mixtral-8x7B vs GPT-3.5

Mixtral 8x7B se distingue dans l’univers des grands modèles de langage par ses performances et sa capacité à gérer de longues séquences de tokens, le plaçant en compétition directe avec le GPT-3.5 d’OpenAI.

Limites de Mixtral 8x7B

Malgré ses performances impressionnantes, Mixtral 8x7B a ses limites. Sa taille plus petite peut limiter sa capacité à gérer des tâches extrêmement complexes ou à comprendre des nuances profondes dans le langage, comparativement à des modèles plus grands comme GPT-4.

La Démarche Open Source de Mistral AI

Engagement envers l’Open Source

Mistral AI a pris la décision audacieuse de rendre ses modèles d’IA open source. Cela permet aux utilisateurs de télécharger, d’expérimenter et d’adapter Mixtral selon leurs besoins spécifiques, ouvrant des routes inédites pour la recherche et l’application pratique.

Partenariat avec Google Cloud

Mistral AI a également établi un partenariat avec Google Cloud pour distribuer des modèles de langage optimisés sur une infrastructure performante, facilitant ainsi leur adoption et utilisation par une communauté mondiale.